Denominado VASA-1, toma el retrato de una persona y hace que literalmente hable, emulando comportamientos conversacionales humanos a través de gesticulaciones faciales y el movimiento de los ojos y la cabeza

Según explican sus creadores, VASA-1, toma el retrato de una persona y hace que literalmente hable, produciendo una muy convincente sincronización entre sus labios y el archivo de audio que se desee.

Microsoft Research, la división investigativa del gigante informático, está desarrollando una herramienta de inteligencia artificial (IA) generativa capaz de crear “rostros parlantes” hiperrealistas a partir de una imagen estática y un clip de audio, de acuerdo con un artículo publicado este martes.

Según explican sus creadores, VASA-1 (abreviatura de ‘Visual Affective Skills Animator’, o ‘Animador de Habilidades Afectivas Visuales’ en español) toma el retrato de una persona y hace que literalmente hable, produciendo una muy convincente sincronización entre sus labios y el archivo de audio que se desee. Además, captura un “amplio espectro de matices faciales y movimientos naturales de la cabeza que contribuyen a la percepción de autenticidad y vivacidad”.

2. Realismo y viveza – ejemplo 1 pic.twitter.com/bnc44C9htE

— Adam (@Adamaestr0_) April 19, 2024

Para demostrar las impresionantes capacidades del modelo, Microsoft compartió varios ejemplos utilizando rostros humanos inexistentes —por razones de privacidad— creados con las redes neuronales de generación de imágenes DALL-E 3 y StyleGAN2. La galería incluye avatares cantando y hablando en sincronización con pistas de audio pregrabadas y muestras de cómo se pueden controlar para que expresen diferentes estados de ánimo o cambien su mirada.

[penci_related_posts dis_pview=”no” dis_pdate=”no” title=”Leer más” background=”” border=”” thumbright=”no” number=”4″ style=”grid” align=”none” withids=”” displayby=”tag” orderby=”date”]

5. Controlabilidad de la generación 1

Ejemplo de dirección de la mirada y distancia de la cabeza, y desplazamientos de la emoción pic.twitter.com/sUWC37aqbG

— Adam (@Adamaestr0_) April 19, 2024

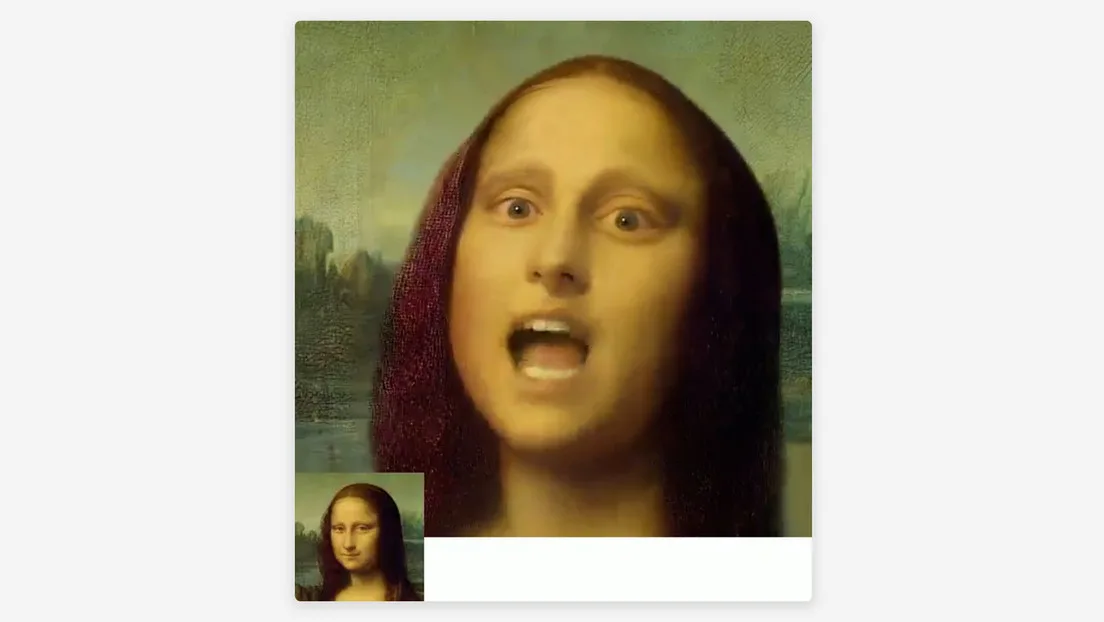

Estas “caras parlantes realistas” emulan comportamientos conversacionales humanos a través de gesticulaciones faciales y el movimiento de los ojos y la cabeza. Sin embargo, VASA-1 también puede procesar “fotografías artísticas, audios cantados y de habla no inglesa”. Como prueba, sus creadores lograron que la famosa obra maestra de Leonardo da Vinci, la ‘Mona Lisa’, interpretara el ‘Paparazzi Rap’ que una vez cantó la actriz Anne Hathaway.

Microsoft acaba de lanzar VASA-1.

Esta IA puede hacer que una sola imagen cante y hable a partir de una referencia de audio de forma expresiva. Similar a EMO de Alibaba

10 ejemplos salvajes ↓

1. Mona Lisa rapeando a Paparazzi pic.twitter.com/74mZH9fTQO

— Adam (@Adamaestr0_) April 19, 2024

Potencialmente peligroso

De momento, VASA-1 está en etapa de aprendizaje y lo revelado esta semana es solo una demostración de la investigación, por lo cual no está disponible para que lo pruebe nadie ajeno al equipo de Microsoft Research. La empresa dejó claro que no tiene previsto lanzarlo al público, en la medida en que es consciente de los peligros de este tipo de tecnología.

El modelo no es perfecto, pero supera significativamente a otros similares de animación de voz en términos de realismo, expresividad y eficiencia, por lo que existe el riesgo de ser “potencialmente mal utilizado” para suplantar identidades, afirma Microsoft. Así, podría prestarse para que personas inescrupulosas falsifiquen material audiovisual creando contenido engañoso o perjudicial, como los famosos ‘deepfakes’ que a menudo implican fraudes o desinformación.

7. Potencia de desentrañamiento 1

Ejemplo de la misma secuencia de movimiento con diferentes fotos pic.twitter.com/vStLKyyGEN

— Adam (@Adamaestr0_) April 19, 2024

“Aun reconociendo la posibilidad de un uso indebido, es imperativo reconocer el considerable potencial positivo de nuestra técnica. Los beneficios —como aumentar la equidad educativa, mejorar la accesibilidad de las personas con problemas de comunicación, ofrecer compañía o apoyo terapéutico a quienes lo necesitan, entre muchos otros— subrayan la importancia de nuestra investigación y de otras exploraciones relacionadas. Nos dedicamos a desarrollar la IA de forma responsable, con el objetivo de mejorar el bienestar humano”, concluye Microsoft.